-

[置顶]软件接口设计怎么做?前后端分离软件接口设计思路

本文关于软件接口设计怎么做?前后端分离软件接口设计思路。好的系统架构离不开好的接口设计,因此,真正懂接口设计的人往往是软件设计队伍中的稀缺型人才。为什么在接口制定标准中说:一流的企业做标准,二流的企业...

-

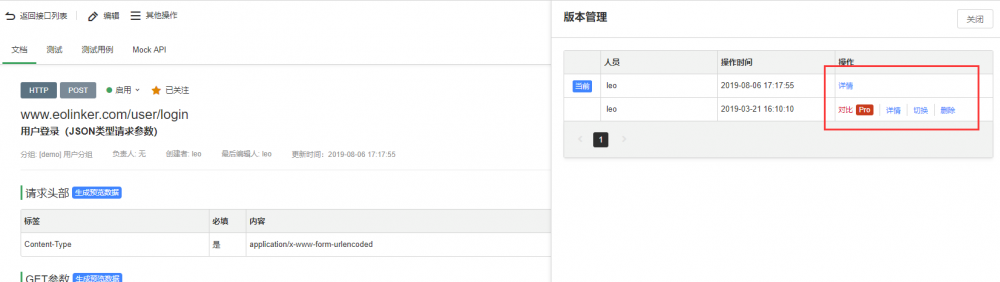

[置顶]接口管理如何做?接口实现版本管理的意义和最佳方法

本文关于接口管理如何做?接口实现版本管理的意义和最佳方法。API版本管理的重要性不言而喻,对于API的设计者和使用者而言,版本管理都有着非常重要的意义。下面会从WEB API 版本管理的角度提供几种常...

-

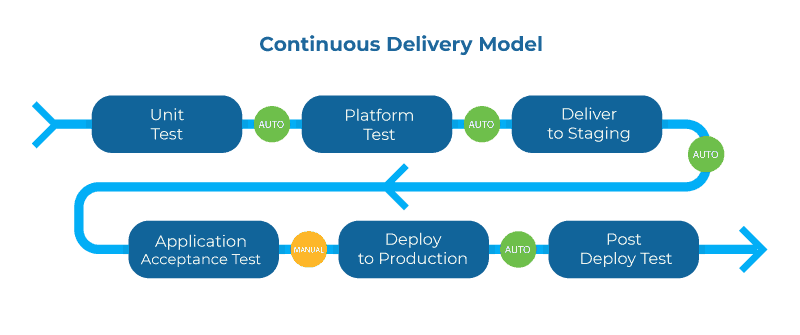

[置顶]实现API管理系统的关键

下面将通过几个关键词的形式说明API管理的重要性和未来的实现方式。1.生命周期管理在整个API生命周期中更深入地集成所有工具将进一步提高生命周期循环的速度,而且更重要的是提供满足消费者需求的API。这...

-

-

-

-

-

-

-

-

-

-

}

else if (tag instanceof ImageTag)//

标签

{

ImageTag image = (ImageTag) list.elementAt(i);

System.out.print(image.getImageURL() + "********");//图片地址

System.out.println(image.getText());//图片文字

}

else// 标签

{

//提取 frame 里 src 属性的链接如

String frame = tag.getText();

int start = frame.indexOf("src=");

frame = frame.substring(start);

int end = frame.indexOf(" ");

if (end == -1)

end = frame.indexOf(">");

frame = frame.substring(5, end - 1);

System.out.println(frame);

}

}

} catch (ParserException e) {

e.printStackTrace();

}

}

简单强大的 StringBean

如果你想要网页中去掉所有的标签后剩下的文本,那就是用 StringBean 吧。以下简单的代码可以帮你解决这样的问题:

清单5

StringBean sb = new StringBean();

sb.setLinks(false);//设置结果中去点链接

sb.setURL(url);//设置你所需要滤掉网页标签的页面 url

System.out.println(sb.getStrings());//打印结果

HtmlParser 提供了强大的类库来处理网页,由于本文旨在简单的介绍,因此只是将与笔者后续爬虫部分有关的关键类库进行了示例说明。感兴趣的读者可以专门来研究一下 HtmlParser 更为强大的类库。

简易爬虫的实现

HttpClient 提供了便利的 HTTP 协议访问,使得我们可以很容易的得到某个网页的源码并保存在本地;HtmlParser 提供了如此简便灵巧的类库,可以从网页中便捷的提取出指向其他网页的超链接。笔者结合这两个开源包,构建了一个简易的网络爬虫。

爬虫 (Crawler) 原理

学过数据结构的读者都知道有向图这种数据结构。如下图所示,如果将网页看成是图中的某一个节点,而将网页中指向其他网页的链接看成是这个节点指向其他节点的边,那么我们很容易将整个 Internet 上的网页建模成一个有向图。理论上,通过遍历算法遍历该图,可以访问到Internet 上的几乎所有的网页。最简单的遍历就是宽度优先以及深度优先。以下笔者实现的简易爬虫就是使用了宽度优先的爬行策略

图 2. 网页关系的建模图

简易爬虫实现流程

在看简易爬虫的实现代码之前,先介绍一下简易爬虫爬取网页的流程。

图 3. 爬虫流程图

各个类的源码以及说明

对应上面的流程图,简易爬虫由下面几个类组成,各个类职责如下:

Crawler.java:爬虫的主方法入口所在的类,实现爬取的主要流程。

LinkDb.java:用来保存已经访问的 url 和待爬取的 url 的类,提供url出对入队操作。

Queue.java: 实现了一个简单的队列,在 LinkDb.java 中使用了此类。

FileDownloader.java:用来下载 url 所指向的网页。

HtmlParserTool.java: 用来抽取出网页中的链接。

LinkFilter.java:一个接口,实现其 accept() 方法用来对抽取的链接进行过滤。

下面是各个类的源码,代码中的注释有比较详细的说明。

清单6 Crawler.java

package com.ie;

import java.util.Set;

public class Crawler {

/* 使用种子 url 初始化 URL 队列*/

private void initCrawlerWithSeeds(String[] seeds)

{

for(int i=0;i

LinkDB.addUnvisitedUrl(seeds[i]);

}

/* 爬取方法*/

public void crawling(String[] seeds)

{

LinkFilter filter = new LinkFilter(){

//提取以 http://twt.edu.cn 开头的链接

public boolean accept(String url) {

if(url.startsWith("http://twt.edu.cn" alt="基于Java HttpClient和Htmlparser实现网络爬虫代码" title="基于Java HttpClient和Htmlparser实现网络爬虫代码" width="200" height="150">